Langkah-langkah Instalasi PySpark pada Hadoop:

1. Download Spark dari websitenya http://spark.apache.org/downloads.html dan pilih yang sesuai

sudo wget https://www-us.apache.org/dist/spark/spark-2.4.3/spark-2.4.3-bin-hadoop2.7.tgz

2. Ekstrak di /usr/local/hadoop/

tar -xzf spark-2.4.3-bin-hadoop2.7.tgz

3. Rename menjadi spark

sudo mv spark-2.4.3-bin-hadoop2.7 spark

3. Edit ~/.bashrc

sudo nano ~/.bashrc

Tambahkan:

export PATH=$PATH:/usr/local/hadoop/spark/bin

export PYSPARK_DRIVER_PYTHON=jupyter

export PYSPARK_DRIVER_PYTHON_OPTS=’notebook’

4. Update

source ~/.bashrc

5. Masuk ke folder spark

Jalankan pyspark

./bin/pyspark

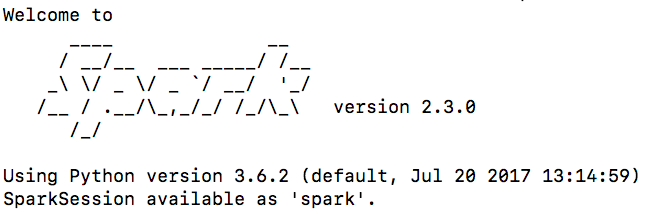

6. Jika berhasil, akan muncul tampilan seperti ini